之前讲到了 SEO 频道,其中极其重要的一步,就是词库的建立了。

词库的整理和收集,一方面可以根据关键词获取到精准的、大量的流量,另一方面也可以了解用户的需求,方便第二步的模板设置。

关键步骤

SEO 词库一般有以下几个关键步骤:

- 抓取

- 扩展

- 过滤

- 补充字段 & 入库

- 清理 & 优化

第一步 关键词抓取

关键词抓取一般有以下几个来源:

- 竞争对手词库

- 第三方工具,如 5118

- PPC 或者其他流量渠道的关键词

抓取的工具也有很多,比如:

- 火车头

- Python - scrapy

- 开发支持

不过需要注意的是,抓取工具一定要支持往下一层抓取(也叫深度抓取),而不能仅限于源页面的抓取。

第二步 关键词扩展

抓取一批数据之后不要急着过滤和使用,要先扩展一批。

这里可以借用搜索引擎的能力和工具进行扩展,有以下几个方式:

- 搜索引擎的搜索框提示词

- 搜索引擎的相关搜索词

- PPC 的扩词工具,如百度推广助手的关键词工具,Google Keyword Planner Tool.

扩展一大堆关键词之后还有非常重要的一步,就是关键词分析,整理关键词组合。

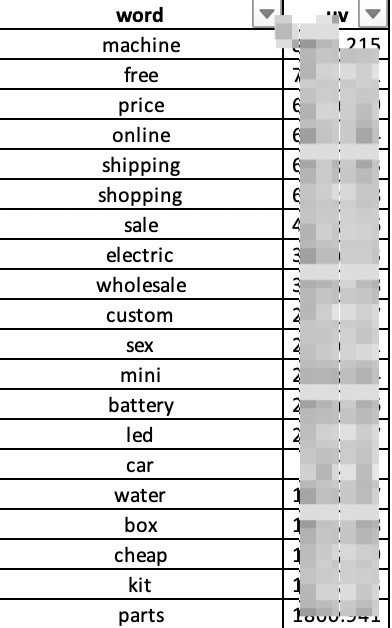

首先,通过分词和整理,可以拿到关键词的词根,以及对应的搜索量。

其次,手工把每个词根对应的关键词组合整理出来,并加上搜索量和出现次数

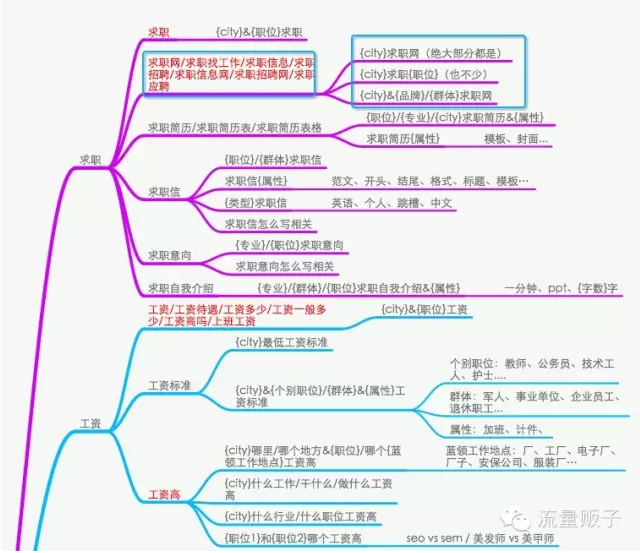

最后,就是考虑这些关键词怎么应用。如果关键词组合的搜索量特别大,而且主题明确且独特,是建议单独开设一个频道,比如 「城市」+ 天气。而对一些比较零散,无明确规则的关键词,则是需要添加到 SEO 频道,比如 “杭州八景”。

借用一张 GoGo闯 博文中的一张图:

注:GoGo闯 有一篇讲关键词分析的文章,这里推荐一下《【如何搭建SEO词库?】SEO关键词分析》。

第三步 关键词过滤

SEO 入库前还需要进行过滤。以下关键词过滤的具体规则(应该是中文最全的规则了):

- 单复数过滤,比如 led light 和 led lights

- 前后顺序调整过滤,比如 led light 和 light led

- 空格处理,其中包含首尾空格去除、多个合并为一个

- 特殊字符处理。除了字母和数字外的其他符号,都是特殊字符

- 大小写处理。一般是全部转换为小写

- 年份替换,比如 2016 替换为 2018

- 去停止词后去重。一定要注意,先去停止词之后再去重,比如 “南京天气” 和 “南京的天气”,这样就可以过滤掉

- 黑名单过滤。这里可以过滤掉包含黑名单里的关键词,而黑名单可人工维护,比如最近的一些敏感词

- 违禁词过滤,比如政治类敏感词、侵权品牌类关键词

- 结果数和相关性档位过滤。根据搜索结果进行过滤,比如相关性档位为 3 的产品少于 20 个,页面就不会创建(或自动添加 noindex)

- 纯数字, 字母过滤。对中文站来讲,纯字母的关键词比较偏向垃圾词,对英文站则不然

- 语种过滤。中文站需要排除掉其他语向的关键词

- 长度过滤。可以过滤掉过长或过短的关键词

- 单词数过滤,可以过滤掉一个单词,或者超过3个单词的关键词

注:上述很多规则来自阿里内部的关键词过滤工具中的功能。

第四步 补充字段 & 入库

入库时除了关键词以外,还需要补充相关的字段(对应每个数据库字段)

一般有以下数据:

- 关键词

- 行业分类,比如属于 3C 行业

- 关键词类型,比如是 price 类

- 添加时间

- 修改时间

- 添加人

- 搜索量

- 百度 / Google 结果数

- 分词结果,比如 “南京|旅游|攻略”

第五步 清理 & 优化

- 清理是为了剔除掉低效的页面,保证频道的效率。比如近一年内没有任何流量的页面。

- 优化是精细化的运营,比如有一批页面一直未抓取,则添加一批内链促进其抓取;或者排名在第二页但仍有流量,则需要稍微给一点内链帮助其上升到第一页

其他高级功能

随着词库规模的扩大,会遇到更多问题。这些都是考虑和解决的。

- 聚类。可以解决页面重复的问题,提高频道效率。

- 分类。可以根据不同的关键词类型,使用不同的模板,以更好的满足用户需求。

- 倾斜。根据搜索量或者转化率,资源向部分页面倾斜。

站群的词库

最后多说一点,我也做过站群的词库。

在站群项目中,内容、抓取量、链接资源都是极其有限的。这个时候,词库就显得极其重要。

一个好的词库,比一般词库的效果要好上几十倍。

而好的词库,甚至不惜人肉整理。几万个关键词人工筛选。

最后

如果对 SEO 词库有任何问题,欢迎留言交流!

或者希望我分享什么话题,也可以留言。

张老师,对于电子元器件行业{part no}型号类型关键词,关键词组合是以纯字母/纯数字/字母&数字组合为主,而且全球这个类型关键词数量有几千万个,但是符合长尾效应,百度对于这种词识别(分词/理解用户需求/排名打分)有什么侧重点嘛?

@peak 这类关键词一般是部署在产品详情页。

搜索引擎在分词上会认为是一个专有名词,在排名上跟其他词也没什么区别。

有一个需要注意的地方,就是这些页面如何避免重复性。因为这些产品的重复度还是很高的,会存在收录的问题。

张老师,我想问一下,火车头如何做深度抓取呢?是不是把所有的分类列表页面的内容页面全部采集下来呢?

@elubs nonono,深度抓取是说抓取的深度。比如我刚开始给了一批URL是第一层,爬虫可以抓到同一个频道的其他页面算第二层,然后爬虫可以在第二层上继续抓第三层、第四层。

张老师,可以分享一个词库整理实例出来呢,让我们学习一下,谢谢。

@elubs 其实很多网站都有这个词库,你可以看下途牛的这个频道。

http://www.tuniu.com/g1602/tipnews-240368/

大师好,小弟非常敬佩大师在SEO技术的经验。我想请大师分享下对这个企业站优化www.szcy99.com排名是如何达到的!这个网站收录不到785个页面,友情链接才5个,也有一些行业站的链接支持,站内优化做得还好,网站内容质量一般,做256个关键词(全部是指数词)在百度首页排名,非常稳定在第一名。小弟因SEO技术水平有限,研究了这个网站很久,百思不得其解(快排?PBN站群?黑帽?)。一个企业网站可以玩得这么牛B,特来请教大师,还望大师指点一二,非常感谢。

@恨铁不成钢 这个站确实有点厉害。可取之处是页面内容非常丰富、移动端也有做相应的适配。域名从 2011年开始。

不过数据来看也有一些问题,比如PC端的百度权重是5,移动端是1。这个数据有点可疑。有点像是快排的原因。但不确定。

@alexkh 非常感谢大师对提问的关注和回复,推测百度及至其它搜索引擎对快排识别能力还是很弱,从目前来看搜索算法,对快排有大很程度上都是免疫的。

张老师,你好,在SEO的道路上一直有一个砍让我不得前进,在看了你这篇文章后,思路大概有了点,想请教个问题,在得到原始词后利用python对原始词做了分词同时获得了包含该词根的搜索量和词数也对关键词做了对应的词根归类,但是在做每个词根项目的词的过滤上,不是很懂,这些特殊符号和无规律的关键词是删除整行还是只是过滤掉关键词中不要的哪部分文字

@SEO爱好者 对于特殊符号,就是过滤掉即可。如果是无规律的关键词,可能用tag频道来承接更合适,因为不太好归类。

清理和优化这个地方有疑问:一个关键词对应一个页面?

@cheng 是的,一个关键词生成一个页面

有没有案例或者样板?

张老师,面对百万级别的词库,不会python清洗,还有啥方法实现么?🤦

@大胡 比较麻烦点,就是用 excel 来操作了,一个个的筛选和过滤。

写的真好,对于初学者来说很受用,感谢老师